FUENTE

En enero de 2020, el gobierno socialista de España, encabezado por Pedro Sánchez, propuso un proyecto de ley de profundo significado cultural y político: una “Ley de Memoria Histórica y Democrática”. Si se aprueba, esta ley completará un esfuerzo de veinte años por parte de la izquierda española para limitar el discurso y remodelar la vida cívica. Establecería un “Consejo de la Memoria” nacional, un órgano del Estado integrado por funcionarios públicos, así como por “expertos” profesionales y representantes de organizaciones no gubernamentales pero políticamente confiables. Elaboraría una política de Estado integral para promover una visión de izquierda de la España de principios y mediados del siglo XX. El proyecto de ley exige la búsqueda de los restos de varios “desaparecidos” del bando republicano en la Guerra Civil española de 1936-1939 y la creación de un “Banco Nacional de ADN” para ayudar a identificarlos. Prescribe la colocación de “placas conmemorativas” en todo el país para identificar sitios y personalidades asociadas con la “memoria democrática”: la memoria de los opositores radicales del régimen de Franco, de los cuales comparativamente pocos estaban a favor de la democracia. La “Ley de Memoria Histórica y Democrática” exige al gobierno español identificar y honrar a las presuntas “víctimas”, sin tener en cuenta el hecho de que muchas probablemente estuvieron involucradas en asesinatos en masa y ejecuciones extrajudiciales.

La ley propuesta es altamente punitiva. Los símbolos, reuniones o declaraciones que se consideran de aprobación del régimen de Franco y de los vencedores de la guerra civil se consideran infracciones a la “memoria histórica y democrática”. Las sanciones propuestas incluyen un elaborado calendario de multas que oscilan entre doscientos y cien mil euros, el cierre por un período de seis meses a dos años de cualquier entidad que infrinja la ley y la confiscación de los medios o bienes involucrados en dichas actividades. Que esta ley restrinja drásticamente la libertad de expresión y viole así la Constitución española es aparentemente irrelevante para el gobierno de Sánchez.

La Ley de Memoria Histórica y Democrática es la propuesta más dramática, arbitraria y punitiva en relación con las discusiones sobre la historia en todo el mundo occidental. Sin embargo, la actitud que refleja es bastante común en la izquierda, que utiliza cada vez más medios gubernamentales o no gubernamentales para restringir y castigar el discurso que defiende puntos de vista, movimientos y figuras de derecha, pasados ??o presentes. Las interpretaciones politizadas de la historia, por supuesto, no son nuevas. Pero la ley propuesta por España es una clara señal de la forma en que la izquierda contemporánea busca utilizar la historia como arma para lograr sus objetivos y silenciar toda disidencia.

El mayor trauma del pasado reciente de España es la Guerra Civil de 1936-1939: la única gran guerra civil revolucionaria moderna que se libró en un país occidental y la lucha europea más importante en los años previos a la Segunda Guerra Mundial. Su violencia más espeluznante no tuvo lugar en el campo de batalla sino en la salvaje represión de ambos bandos contra sus oponentes. Los escuadrones de la muerte republicanos ejecutaron a unos cincuenta y cinco mil adversarios, y los nacionalistas opositores al menos a tantos, si no más, seguidos por quince mil más que fueron condenados por tribunales militares una vez terminadas las luchas. Estas sombrías estadísticas incluyen la masacre de casi siete mil miembros del clero, en el estallido anticlerical más sangriento fuera del mundo comunista. El número de muertos se puede comparar con lo ocurrido en Rusia y Finlandia en 1918-1920, y supera los casos de Letonia y Hungría. Además, a diferencia de las sangrientas secuelas de la Primera Guerra Mundial en Europa del Este, todo esto tuvo lugar en un país de Europa Occidental cubierto extensamente (aunque no siempre con precisión) por la prensa internacional. A la guerra civil le siguió la dictadura de derecha más larga que jamás haya gobernado un gran país de Europa occidental.

El régimen de Franco fue implacable y tenía mucho de qué responder, pero entre 1950 y 1975 presidió la modernización y transformación de España, un logro que había eludido a los líderes del país durante tres siglos. Este proceso podría compararse con el más reciente “modelo chino” de dictadura modernizadora, aunque en el caso de España fue seguido por una rápida transición a la democracia bajo el sucesor de Franco, el rey Juan Carlos.

Durante la convulsa historia moderna de España, la tendencia en la mayoría de los regímenes de transición había sido que los ganadores se vengaran de los perdedores. En España, se refieren al fin del régimen de Franco y a la fundación de la democracia actual como la “Transición Democrática”. En esta transición, los nuevos líderes estaban decididos a no repetir el pasado y reavivar viejos conflictos. Su objetivo era hacer borrón y cuenta nueva histórica, abriendo la transición a la plena participación de todos. El resultado fue la primera constitución democráticamente consensuada de España, ratificada por el electorado en 1978. Durante más de un cuarto de siglo, el sistema de monarquía parlamentaria de la constitución pareció funcionar bien, atrayendo elogios internacionales a pesar de una corrupción cada vez más generalizada.

A la luz del historial negativo de los regímenes de transición anteriores, hubo acuerdo entre todas las fuerzas políticas, desde los conservadores hasta los comunistas, en que los argumentos de la historia no debían utilizarse como armas políticas. En 1977, los partidos de izquierda insistieron unánimemente en una votación de amnistía universal para todos los delitos imputados o motivados políticamente en el pasado, sin excepción. Esperaban que la historia dejara de ser un tema invocado habitualmente en política. A los moderados y a los derechistas no se les debía llamar “franquistas” o “fascistas”, y a los izquierdistas no se les debía llamar “revolucionarios” o “rojos”.

Este consenso se mantuvo en general durante casi dos décadas. En 1993, sin embargo, el partido socialista de Felipe González, que había gobernado ininterrumpidamente durante once años, corría peligro de perder las elecciones. La campaña de González comenzó a insistir en que un voto por el moderado Partido Popular sería un voto a favor del retorno al franquismo. Esta retórica puede haber alentado otra victoria socialista en 1993, pero no sirvió de nada tres años después, cuando los socialistas perdieron, ni tampoco en 2000, cuando el Partido Popular obtuvo una mayoría absoluta en el parlamento. El primer ministro del partido victorioso, José María Aznar, declaró en 2002 que en España por fin se había enterrado el uso de armas del pasado reciente con fines partidistas. Él estaba equivocado.

Los viejos hábitos de denuncia regresaron y la politización de la historia se convirtió en una táctica cada vez más común de la izquierda, así como de los separatistas regionales, que la habían adoptado incluso antes. Los separatistas a menudo se basan en tropos ultranacionalistas que mitizan el pasado de una manera a veces fantástica o fabrican un pasado de la nada. En esto sólo se sienten alentados por las tendencias del progresismo occidental, que durante mucho tiempo ha abusado de la historia para servir a sus fines. En esto, como en muchas otras cosas, España no es “diferente”, como dice el viejo tópico del turismo. Es como en todas partes, sólo que más.

A medida que la política de la memoria se calentaba en los primeros años del siglo XXI, los historiadores se sumaron invocando el estudio del siglo XX de la “memoria histórica” o “memoria colectiva” realizado por académicos franceses como Maurice Halbwachs y Pierre Nora. A menudo no reconocieron que estos académicos habían enfatizado que la “memoria colectiva” refleja o expresa actitudes actuales y no puede revelar la verdad de la historia de ninguna manera confiable. Como observa Wulf Kansteiner, la llamada “memoria colectiva no es historia”; es “tanto el resultado de una manipulación consciente” como de un recuerdo preciso. Enrique Gavilán subraya que “el trabajo de los historiadores no presupone la exactitud de la memoria. Por el contrario, es plenamente consciente de las inevitables deficiencias de la memoria. Los historiadores saben que la memoria no sólo deforma la comprensión de lo ocurrido, sino que de hecho lo hace inevitablemente”.

Varios destacados académicos enfatizaron que la “memoria histórica” tal como la usa la izquierda española es un oxímoron. La memoria humana es individual, subjetiva y frecuentemente falaz. Incluso las personas de buena fe recuerdan a menudo detalles que difieren de lo que realmente sucedió. La historia, tal como la investigan los académicos, por el contrario, no es individual ni subjetiva. Requiere el estudio objetivo y empírico de documentos, otros datos y artefactos. Es un proceso supraindividual emprendido por una comunidad de académicos que debaten y contrastan los resultados y se esfuerzan por ser lo más objetivos posible.

Pero estas advertencias contra el uso político de la “memoria histórica” carecieron de importancia. En el año 2000, la izquierda había perdido temporalmente gran parte de su poder. Con el neoliberalismo en ascenso, los socialistas fracasaron en dos elecciones sucesivas y el Partido Comunista original se desintegró. Las doctrinas socialdemócratas del siglo XX habían perdido parte de su poder de persuasión. Se volvió cada vez más urgente encontrar nuevos términos argumentativos, y la “memoria histórica” jugó un papel importante en el regreso de la izquierda al poder en 2004, después de un importante ataque terrorista en Madrid. Se volvió común argumentar que la democratización se había basado en un supuesto “pacto de silencio”, que se negaba a reconocer los crímenes del franquismo y no honraba a las víctimas históricas.

Pero el “pacto de silencio” es un eslogan propagandístico. Nunca existió tal cosa. Todo lo contrario caracterizó la Transición Democrática de finales de los años 1970, que se había basado en una aguda conciencia de los fracasos y crímenes del pasado y en la determinación de que no se repitieran. Como ha escrito Paloma Aguilar, la principal investigadora sobre el papel de la memoria colectiva en estos años, “Pocos procesos de cambio político se han inspirado tanto en la memoria del pasado, y en las lecciones asociadas a él, como el caso español. » Sería difícil encontrar otro caso en el que la conciencia fuera mayor. Lo que se acordó no fue “silencio”, sino el entendimiento de que los conflictos históricos deberían dejarse en manos de los historiadores y que los políticos no deberían revivir viejos agravios en su lucha por el poder.

Además de “callar”, durante la Transición Democrática historiadores y periodistas actuaron al extremo en todos los medios de comunicación, inundando el país con estudios y relatos de la guerra civil y del franquismo que no disimulaban los aspectos más atroces. A los veteranos del ejército republicano anteriormente derrotados se les concedió pleno reconocimiento y pensiones, con los correspondientes honores. Las ceremonias oficiales de homenaje patrocinadas por el Estado español a los republicanos caídos y a los ex líderes revolucionarios responsables de muchas atrocidades regresaron a España en medio de aplausos públicos. Posteriormente aparecieron estudios académicos detallados y objetivos que, aunque incompletos, por primera vez situaron las explicaciones de las represiones por ambos bandos sobre una base más precisa. Todo esto era lo opuesto al “olvido”, y era mucho más cuidadoso y exacto que la agitación actual sobre la memoria histórica, que es alérgica a los hechos o a la investigación seria.

La ideología de la izquierda española del siglo XXI rechaza casi todos los aspectos del pasado. Es hostil a la mayoría de los valores tradicionales, a diferencia de la socialdemocracia clásica o incluso, en algunos aspectos, del marxismo-leninismo revolucionario. La nueva ideología enfatiza la revolución cultural y sexual. La historia es un juicio político farsa, poco más que un registro de héroes y villanos. Su función principal es desenmascarar a los opresores, separando a las generaciones pasadas en víctimas que deben ser afirmadas y santificadas y victimarios que deben ser silenciados y demonizados. Proyecta culpa sobre los chivos expiatorios del pasado, especialmente si de alguna manera pueden identificarse con sus oponentes políticos en el presente. A los muertos no se les permite descansar en paz, sino que se les alista en la lucha eterna entre el bien y el mal. Francisco Franco, desaparecido durante casi medio siglo, debe ser desenterrado litúrgicamente y vuelto a enterrar. La clasificación de víctimas y victimarios adquiere un significado cultual. Los primeros son honrados y desempeñan papeles salvíficos, de forma muy similar a como lo hacen los héroes en la cultura tradicional. Estos últimos son ritualmente condenados y expulsados. Esta farsa de la “memoria” es un pastiche grotesco y secularizado del cristianismo, elaborado por anticlericales radicales. Es, a su manera, incluso más “religioso” que el culto a la razón en la Revolución Francesa.

Cuando los socialistas españoles intentaron por primera vez imponer restricciones a la memoria histórica a principios de la década de 2000, sus propuestas encontraron duras críticas por parte de varios destacados historiadores profesionales asociados con el propio partido. Pero su propuesta, algo modificada, fue promulgada por el gobierno de José Luis Rodríguez Zapatero en 2007. Esta medida sustituyó el término “memoria histórica” por “memoria democrática”, aunque, en sentido estricto, la memoria democrática sólo puede aplicarse a la reciente Transición misma. . La democracia genuina nunca existió en España antes de 1977, con las excepciones parciales de los últimos años de la anterior monarquía constitucional y los gobiernos de centroderecha de 1933-1935, contra los cuales los socialistas españoles se levantaron en una insurrección revolucionaria.

El esfuerzo de 2007 tuvo dos características especialmente descaradas. El primero fue simplemente la arrogancia de un gobierno que pretendía prescribir qué juicio debía hacerse sobre la historia reciente. El segundo fue la promoción de la “memoria democrática” y un culto al victimismo por parte de los socialistas y los herederos políticos de los ex comunistas, cuando estas eran las mismas fuerzas que habían subvertido el intento de democracia española en la década de 1930 y habían masacrado a sus adversarios. en gran número. Los precursores de la izquierda actual en España desempeñaron papeles destacados en las ejecuciones masivas. Ningún otro partido gobernante en una democracia occidental tiene tal historial de derramamiento de sangre, sin embargo, esta misma organización política, en lugar de emprender una autocrítica histórica y un arrepentimiento, corre un velo sobre su propio pasado mientras acusa a sus enemigos, casi todos ellos de larga data. desde muerto. La hipocresía es moneda común en la política, pero esto establece una especie de récord.

La resurrección de la “memoria histórica” en España plantea una serie de argumentos que no son producto de una investigación desinteresada, sino que se derivan de los principales temas propagandísticos del Frente Popular sobre la propia guerra civil. Ignora deliberadamente el largo historial de violencia izquierdista antes y durante la guerra, junto con la revolución altamente destructiva en la zona del Frente Popular. Quienes proponen poner fin al “pacto de silencio” insisten en que la izquierda luchó sólo por la “democracia” en oposición al “fascismo”, al que a su vez se le considera responsable de toda la violencia política. Como en otros países occidentales, los medios de comunicación y el sistema educativo en España están dominados por la izquierda, que impone lo que los españoles llaman el pensamiento único (pensamiento unipolar o excluyente). Los moderados y conservadores rara vez hablan, por temor a ser tildados de “franquistas” o “fascistas”, y en su timidez ceden la plaza pública. Este tipo de situaciones son comunes en todo Occidente, pero el paralelo más cercano a España puede ser el de Grecia en las últimas décadas. En Italia, por el contrario, ha tendido a haber algo más de tolerancia y apertura.

Los debates antes de su promulgación significaron que la ley de 2007 tuvo que ser modificada para declarar que “no es tarea del legislador implantar una memoria colectiva específica”. Pero la ley contradice esta calificación al ordenar a los futuros gobiernos que implementen “políticas públicas dirigidas a. . . el desarrollo de la memoria democrática”. Durante los cuatro años posteriores a la aprobación de la ley, la financiación pública apoyó una larga serie de proyectos de discusión histórica, agitación política y búsqueda de los restos de las víctimas de la represión de la guerra civil. Esta última era la más cercana a una actividad cívica adecuada, aunque se veía comprometida por su falta de interés por las víctimas de la derecha. Se recuperaron los restos de varios cientos de izquierdistas ejecutados, lejos de los “miles” que se decía que yacían en “fosas comunes”. La financiación llegó a su fin con la caída del gobierno de Zapatero en 2011.

La izquierda aprobó en oposición al gobierno de centroderecha de Mariano Rajoy (2011-2018). Durante este tiempo, su énfasis en la memoria histórica no hizo más que intensificarse. Poco antes de finales de 2017, la minoría socialista presentó una nueva legislación, mucho más ambiciosa que la ley de 2007. Decretó la criminalización al estilo soviético de ciertos tipos de declaraciones y actividades relacionadas con el pasado reciente. Pidió la formación de una Comisión de la Verdad para recomendar el procesamiento de quienes violaran sus normas y prescribir multas e incluso penas de prisión.

En ese momento, la draconiana medida languideció por falta de apoyo. Pero una serie de cuatro elecciones parlamentarias en cuatro años brindó la oportunidad de avanzar en la militarización de la historia después de la formación de un gobierno socialista minoritario bajo Pedro Sánchez en 2018. Incapaz durante dos años de aprobar un presupuesto regular, y con su margen de maniobra en Aunque la mayoría de las cuestiones eran limitadas, la administración socialista decidió seguir adelante con su batalla por el control total de la memoria histórica. En 2019, obtuvo la aprobación parlamentaria para retirar los restos de Franco de su lugar de descanso en el monumento a los muertos de la guerra civil, la gran Basílica Pontificia del Valle de los Caídos, cerca de Madrid, considerada por algunos el mayor monumento construido. en el siglo veinte. El gobierno argumentó que el Valle, el segundo sitio más visitado de España, se había convertido en un monumento al difunto dictador.

Ocho años antes, el gobierno de Zapatero había nombrado una comisión nacional de expertos para abordar la cuestión del lugar de descanso final de Franco. Concluyó que era aconsejable volver a enterrar en otro lugar, pero sólo después de que se hubiera logrado un consenso entre el Estado, las autoridades religiosas y la familia Franco. También recomendó que se concediera a este último autoridad para elegir el nuevo sitio. Estas recomendaciones fueron ignoradas por el gobierno de Sánchez, que alegó “extrema urgencia” (¡después de cuarenta y cuatro años!), mientras que los diputados centristas se abstuvieron, al igual que la mayoría de los diputados conservadores. Se rechazó un recurso ante el Tribunal Supremo de España. La recomendación anterior de la comisión nacional fue ignorada. El tribunal negó el permiso a los nietos de Franco para volver a enterrar los restos en la cripta familiar de la Almudena, la catedral de Madrid. Semejante directiva (que niega el derecho a enterrar a una figura histórica importante en el lugar de enterramiento de su familia) probablemente no tenga precedentes entre los gobiernos constitucionales occidentales.

La Basílica Pontificia está protegida por la ley española y la jurisdicción eclesiástica. Aunque el abad del monasterio encargado de la basílica se opuso enérgicamente a la profanación, al igual que muchos portavoces privados, las autoridades de la Iglesia aceptaron tácitamente la iniciativa. Los restos de Franco fueron rápidamente desenterrados y enterrados nuevamente junto a los de su esposa en un pequeño monumento cerca de su antigua residencia oficial, ahora un sitio histórico nacional.

Insatisfecha con estas medidas, la última propuesta legislativa de 2020 pretende, de manera macabra, desenterrar los restos por segunda vez y reenterrarlos en un sitio diferente, al que se negaría todo acceso público. El Valle de los Caídos, con su notable basílica y su gran cruz en la cima de una colina, sería secularizado y nacionalizado, en términos aún por negociar. Además, cualquier “asociación” o “fundación” que “incite directa o indirectamente al odio o la violencia” hacia los revolucionarios violentos de 1934-1939 o hacia los a veces antidemocráticos oponentes del régimen de Franco sería declarada ilegal. (La definición de “odio” sigue sin estar clara.) Esta última disposición parece ser principalmente una declaración de culpabilidad contra la Fundación Franco, que se dedica a fomentar su propia versión de la historia del difunto dictador. Sus derechos están garantizados por la Constitución española, al igual que la libertad de religión y, en consecuencia, la inviolabilidad de los santuarios. Pero estos aspectos del Estado de derecho no parecen tener importancia para quienes en España se presentan como defensores de la “memoria democrática”.

Todaa la complejidad de las cuestiones involucradas en la Guerra Civil Española de 1936-1939 es reconocida casi universalmente por los académicos profesionales. Reducir la política revolucionaria de la izquierda de 1934 a 1939 a “democracia” y convertir a esas facciones en custodios de la “memoria democrática” es una burla de la historia. Lo mismo se aplica a la supresión deliberada de la más mínima referencia a la violencia masiva y al saqueo y destrucción generalizados provocados por los revolucionarios. La actual democracia española no se basa en modo alguno en su régimen asesino. Se basa en principios constitucionales históricos españoles y en las normas de la Europa democrática contemporánea. Las implicaciones de la ley de la memoria equivalen a afirmar que los seguidores contrarrevolucionarios del general Anton Denikin en la Guerra Civil Rusa de 1917-1921 se oponían de algún modo a la “democracia”, en lugar de combatir a los fundadores del totalitarismo del siglo XX.

Sumándose a esta hipocresía, el gobierno de Sánchez ha ayudado a rehabilitar a los herederos del ala terrorista del nacionalismo vasco, quienes proporcionan los votos parlamentarios cruciales de los que depende para mantenerse en el poder. Los nacionalistas vascos responsables de más de trescientas víctimas del terrorismo nunca han sido procesados. Aquí, al parecer, el gobierno de Sánchez busca borrar la memoria de las víctimas, porque tales recuerdos son políticamente inconvenientes.

En la Europa actual, la mayoría de las controversias históricas se refieren a la Segunda Guerra Mundial. Varios países han legislado para censurar los comentarios históricos considerados injuriosos o escandalosos, como la negación del Holocausto. Algunas censuras van mucho más allá y se extienden incluso a la interpretación de textos controvertidos de la Biblia.

La ley propuesta en España, sin embargo, marca una nueva tendencia a convertir la historia en un arma en nombre de interpretaciones demostrablemente distorsionadas y falsificadas que son políticamente útiles más que intelectualmente creíbles. Esta tendencia no es producto de la ignorancia sino de un intenso partidismo. Refleja una mentalidad milenaria que busca purgar a la sociedad de influencias y actitudes provenientes del pasado para lograr una especie de utopía purificada. Fundamental para esta búsqueda es la búsqueda no reconocida de un sustituto de la fe religiosa. Esta nueva fe política busca construir un mundo de perfecta igualdad y valores armonizados. Imagina que se puede avanzar hacia este mundo inmaculado presentando figuras políticamente correctas como mártires que murieron por la utopía venidera. Esto requiere, a su vez, convertirlos en chivos expiatorios y expulsar a sus supuestos victimarios, quienes supuestamente son los autores de los males que asedian a la sociedad en su estado actual e irredento.

La tendencia a convertir la historia en un arma siempre ha sido fuerte en los movimientos ultranacionalistas y también es prominente entre las fuerzas neotradicionales del mundo no occidental. En el pasado, ha sido empleado por movimientos revolucionarios de diversos tipos. Sólo recientemente ha sido adoptada por sectores importantes de los principales partidos políticos occidentales, una señal de su radicalización y su giro hacia medidas represivas de control social, incluso de control mental.

La pandemia ha paralizado el examen de la “Ley de Memoria Histórica y Democrática”. España ha sufrido proporcionalmente la mayor devastación de cualquier país occidental, debido en parte a la incompetencia e irresponsabilidad de su gobierno. Por el momento, la extrema izquierda parece más obsesionada con deslegitimar la monarquía parlamentaria establecida por la Constitución de 1978, con la esperanza de reemplazarla con una república radical al estilo latinoamericano. No obstante, la propuesta de institucionalizar la “memoria democrática” permanece. Es el proyecto más elaborado del mundo occidental para la militarización sistemática de la historia. Confirma la inclinación de la izquierda española, expresada por primera vez hace dos siglos, por adoptar las versiones más extremas de las ideas de izquierda. Es una señal de hacia dónde se dirigirán los movimientos de izquierda en todo el mundo desarrollado si se les permite avanzar sin oposición.

Stanley G. Payne es profesor emérito de Historia Jaume Vicens Vives y Hilldale en la Universidad de Wisconsin-Madison.

Foto de Richard Mortel vía Creative Commons

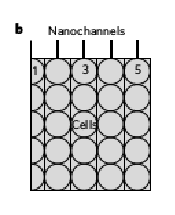

Diagrama que nos muestra el proceso de la tecnología TNT en donde el electrón positivo se inserta intradérmicamente y el electrón negativo se une a la solución cargada. Entonces, se aplica un campo eléctrico de 250V para nanoperforar la membrana celular e inyectar la carga en el citosol.

Diagrama que nos muestra el proceso de la tecnología TNT en donde el electrón positivo se inserta intradérmicamente y el electrón negativo se une a la solución cargada. Entonces, se aplica un campo eléctrico de 250V para nanoperforar la membrana celular e inyectar la carga en el citosol. Los nanocanales están en contacto con la parte más externa de la membrana celular.

Los nanocanales están en contacto con la parte más externa de la membrana celular. Perfil de poración con diferentes células en donde aquellas tratadas con TNT están representadas con líneas continuas y aquellas tratadas con BEP están representadas con líneas discontinuas.

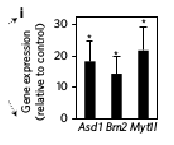

Perfil de poración con diferentes células en donde aquellas tratadas con TNT están representadas con líneas continuas y aquellas tratadas con BEP están representadas con líneas discontinuas. Resultados de la expresión de la expresión de AMB para TNT versus para BEP 24 horas después de la transfección (proceso que consiste en introducir material genético externo a células eucariotas mediante plásmidos u otros). BEP fue llevada a cabo vía inyección intradermal de los plásmidos de AMB seguido de un pulso de campo eléctrico.

Resultados de la expresión de la expresión de AMB para TNT versus para BEP 24 horas después de la transfección (proceso que consiste en introducir material genético externo a células eucariotas mediante plásmidos u otros). BEP fue llevada a cabo vía inyección intradermal de los plásmidos de AMB seguido de un pulso de campo eléctrico.

IVIS (Sistema de escaneo in vivo) [Figura 1e] y imágenes de microscopía confocal (microscopía que aumenta la resolución óptica y el contraste de un micrógrafo) [Figura 1f] de piel de ratón después de un tratamiento con TNT y ADN marcado junto con los factores ABM, respectivamente.

IVIS (Sistema de escaneo in vivo) [Figura 1e] y imágenes de microscopía confocal (microscopía que aumenta la resolución óptica y el contraste de un micrógrafo) [Figura 1f] de piel de ratón después de un tratamiento con TNT y ADN marcado junto con los factores ABM, respectivamente. En esta gráfica se ven los resultados de la expresión genética de qRT-PCR en la epidermis y la dermis y se demuestra que la expresión de los genes pasó más allá del límite de transfección epidérmica.

En esta gráfica se ven los resultados de la expresión genética de qRT-PCR en la epidermis y la dermis y se demuestra que la expresión de los genes pasó más allá del límite de transfección epidérmica. En este diagrama podemos ver el proceso de la propagación transfeccional mediada por EVs (vesículas extracelulares) desde la epidermis a la dermis.

En este diagrama podemos ver el proceso de la propagación transfeccional mediada por EVs (vesículas extracelulares) desde la epidermis a la dermis. Análisis de qRT-PCR de la carga de EVs donde se muestran cargas significantes de ABM cADNs/mARNs.

Análisis de qRT-PCR de la carga de EVs donde se muestran cargas significantes de ABM cADNs/mARNs.

Con esta miografía confocal vemos el fibroblasto embriónico de un ratón (rojo) que ha absorbido las EVs a las que les habían puesto ABM.

Con esta miografía confocal vemos el fibroblasto embriónico de un ratón (rojo) que ha absorbido las EVs a las que les habían puesto ABM. Tejido de fibroblastos embriónicos de ratón en el que se muestran las iNs (neuronas inducidas) el 7º día después de haber sido expuestas a 24 horas de EVs con ABM.

Tejido de fibroblastos embriónicos de ratón en el que se muestran las iNs (neuronas inducidas) el 7º día después de haber sido expuestas a 24 horas de EVs con ABM.

Resultados que muestran el incremento de la expresión Tuj1 (m) y el incremento de neurofilamentos (NF) (n) en la piel después de una transfección de ABM.

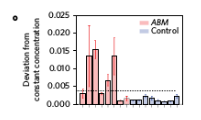

Resultados que muestran el incremento de la expresión Tuj1 (m) y el incremento de neurofilamentos (NF) (n) en la piel después de una transfección de ABM. La actividad electrofisiológica está mostrada con barras representativas e indica cambios en la concentración iónica de la matriz extracelular. Esto es el resultado de la estimulación de un grupo de neuronas.

La actividad electrofisiológica está mostrada con barras representativas e indica cambios en la concentración iónica de la matriz extracelular. Esto es el resultado de la estimulación de un grupo de neuronas.

Con un tratamiento de una sola sesión y unos pocos segundos de duración se consiguió un aumento de la angiogénesis (Pecam-1, vWF) del tejido de la piel.

Con un tratamiento de una sola sesión y unos pocos segundos de duración se consiguió un aumento de la angiogénesis (Pecam-1, vWF) del tejido de la piel.

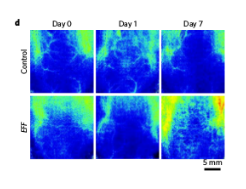

Imágenes con HRLS que muestran que se estimula la perfusión (flujo sanguíneo) en el área tratada con EFF a lo largo del tiempo.

Imágenes con HRLS que muestran que se estimula la perfusión (flujo sanguíneo) en el área tratada con EFF a lo largo del tiempo. Este escáner de ultrasonido de la piel tratada con EFF confirmó la presencia de vasos sanguíneos (@3mm de la superficie) con comportamiento pulsátil, lo que sugiere un éxito de la anastómosis (término que describe la unión de 2 elementos anatómicos con otros del mismo animal, en este caso) con el sistema circulatorio matriz.

Este escáner de ultrasonido de la piel tratada con EFF confirmó la presencia de vasos sanguíneos (@3mm de la superficie) con comportamiento pulsátil, lo que sugiere un éxito de la anastómosis (término que describe la unión de 2 elementos anatómicos con otros del mismo animal, en este caso) con el sistema circulatorio matriz. Experimento con un colgajo de piel que muestra el incremento de la necrosis del colgajo en el grupo de control en comparación con la piel tratada con EFF.

Experimento con un colgajo de piel que muestra el incremento de la necrosis del colgajo en el grupo de control en comparación con la piel tratada con EFF. Escaneo que muestra el incremento del flujo sanguíneo en el tejido implantado tratado con EFF mediante TNT.

Escaneo que muestra el incremento del flujo sanguíneo en el tejido implantado tratado con EFF mediante TNT. Gráfico que recoge la cuantificación de la necrosis del pellejo de piel.

Gráfico que recoge la cuantificación de la necrosis del pellejo de piel.

Las articulaciones de los ratones del grupo de control muestran una mayor necrosis de tejidos que las articulaciones tratadas con EFF.

Las articulaciones de los ratones del grupo de control muestran una mayor necrosis de tejidos que las articulaciones tratadas con EFF. Las medidas basadas en NMR de energéticas musculares confirmaron un incremento en los niveles de ATP y PCR para las articulaciones tratadas con EFF en comparación con el grupo de control.

Las medidas basadas en NMR de energéticas musculares confirmaron un incremento en los niveles de ATP y PCR para las articulaciones tratadas con EFF en comparación con el grupo de control. Análisis por immunofluorescencia del músculo gastrocnemio que muestra una estimulación de la angiogénesis.

Análisis por immunofluorescencia del músculo gastrocnemio que muestra una estimulación de la angiogénesis.

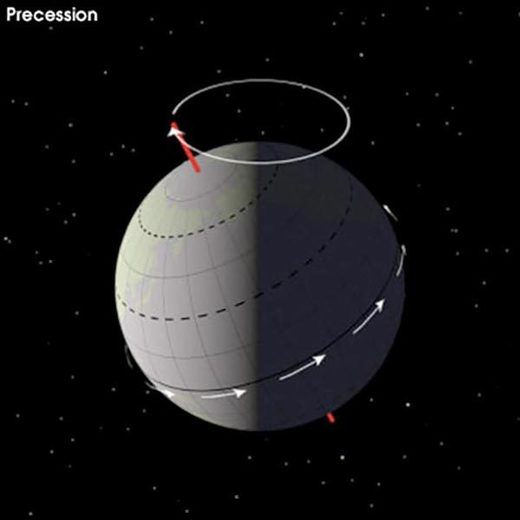

Comentario: Para ser claros, esto no es una admisión explícita por parte de la NASA de que «el cambio climático es un fenómeno solar». De hecho, hubo un tiempo en el que las instituciones tan cacareadas estaban abiertas a tales ideas, pero ese tiempo ya pasó. Hoy ‘¡todos están a bordo del tren hecho por el hombre!’… aunque, como implica el artículo, los científicos y administradores de la NASA seguramente deben saber, en la intimidad de sus propios pensamientos, que el clima está regulado por fuerzas mucho mayores que la contaminación y pedos de vaca. Por lo tanto, es deseo del autor original que ‘la NASA admita’…Un aspecto que no se menciona en el artículo es el efecto que el entorno cósmico tiene sobre el clima del planeta. Sin embargo, quienes perpetúan la narrativa del «cambio climático provocado por el hombre» nos están vendiendo un montón de hockey sobre caballos.

Ver también: